수학 통계 컴공 경영

1. 선형대수학 관련 질문

- 예상 질문: 선형대수의 기본 개념을 아는지? 역행렬의 존재 여부, Rank, SVD(특이값 분해) 등을 알고 있는지?

- 준비 방법: 선형대수학의 기본 개념을 확실히 이해하고, 역행렬과 Rank, SVD의 정의와 의미를 숙지하세요. 특히, 데이터 분석에 자주 사용되는 행렬 연산의 응용에 대한 간단한 예시를 준비하는 것이 좋습니다 .

- 예상 질문:

- 선형대수의 기본 개념을 설명할 수 있는가?

- 역행렬이 존재하지 않는 행렬이 있는가? 그 이유는 무엇인가?

- Rank(랭크)와 SVD(특이값 분해)에 대해 설명할 수 있는가?

1. 선형대수의 기본 개념

- 답변: 선형대수학은 벡터 공간과 선형 변환을 다루는 수학의 한 분야입니다. 벡터와 행렬을 사용하여 여러 차원의 데이터를 분석하고, 다양한 계산을 할 수 있는 기법을 제공합니다.

- 선형 결합, 기저, 차원과 같은 개념이 핵심입니다. 예를 들어, 벡터는 공간 내의 방향과 크기를 가지는 객체이며, 행렬은 벡터에 선형 변환을 적용하는 연산자 역할을 합니다.

2. 역행렬의 존재 여부

- 답변: 모든 행렬이 역행렬을 가지는 것은 아닙니다. 역행렬이 존재하려면, 행렬은 정사각행렬이어야 하며 **행렬식(determinant)**이 0이 아니어야 합니다. 만약 행렬식이 0이면, 행렬은 역행렬을 가지지 않으며 이를 **특이행렬(singular matrix)**이라고 합니다. 예를 들어, 2x2 행렬 (abcd)\begin{pmatrix} a & b \\ c & d \end{pmatrix}(acbd)에서 ad−bc=0ad - bc = 0ad−bc=0이면 역행렬이 존재하지 않습니다.

3. Rank(랭크)

- 답변: 랭크(Rank)는 행렬에서 독립적인 행 또는 열 벡터의 최대 개수를 나타냅니다. 이는 행렬의 선형 독립성의 척도이며, 주어진 행렬이 몇 개의 독립적인 차원을 가지고 있는지 나타냅니다. 예를 들어, 행렬의 랭크가 2라면, 해당 행렬은 2차원 벡터 공간에서 모든 점을 설명할 수 있는 독립적인 축을 가진다는 뜻입니다.

4. SVD(특이값 분해)

- 답변: 특이값 분해(Singular Value Decomposition, SVD)는 행렬을 세 개의 행렬의 곱으로 분해하는 방법입니다: A=UΣVTA = UΣV^TA=UΣVT, 여기서 UUU와 VVV는 직교 행렬이고, ΣΣΣ는 대각 행렬입니다. 이 방법은 데이터 압축이나 노이즈 제거, 차원 축소 등에 유용하게 사용됩니다. SVD는 특히 데이터 분석과 머신러닝에서 유용하며, 행렬의 특이값을 통해 행렬의 특성을 분석할 수 있습니다. 예를 들어, SVD는 이미지 압축에서 자주 사용되며, 많은 정보가 없는 작은 특이값을 제거하여 데이터 크기를 줄일 수 있습니다.

2. 미적분과 경사하강법 관련 질문

- 예상 질문: 경사하강법을 알고 있는가? 경사하강법이 적용되는 2차 함수의 기울기 0의 의미를 설명할 수 있는가?

- 준비 방법: 경사하강법의 원리와 경사하강법이 기울기가 0일 때 어떻게 작동하는지 설명할 수 있어야 합니다. 경사하강법은 머신러닝 모델의 최적화 과정에서 중요한 개념이므로 이론과 응용 사례를 함께 설명할 수 있도록 준비하세요

-

예상 질문:

- 경사하강법(Gradient Descent)을 알고 있는가?

- 경사하강법이 적용되는 2차 함수에서 기울기가 0인 지점의 의미는 무엇인가?

1. 경사하강법의 원리

- 답변: 경사하강법(Gradient Descent)은 머신러닝에서 비용 함수(loss function)를 최소화하기 위해 사용하는 최적화 알고리즘입니다. 경사하강법은 함수의 기울기(gradient)를 이용해, 함수의 최솟값을 찾아가는 과정을 반복적으로 수행합니다. 이 알고리즘은 주어진 함수의 기울기를 계산하고, 기울기가 내려가는 방향으로 일정한 비율만큼 이동하면서 비용 함수를 최소화하는 방향으로 업데이트됩니다. 예를 들어, 경사하강법은 선형 회귀나 로지스틱 회귀 같은 모델의 가중치(weight)를 최적화할 때 많이 사용됩니다.

주요 개념:

- 학습률(learning rate): 한 번의 업데이트 시 이동하는 크기를 결정하는 매개변수입니다. 학습률이 너무 크면 최적점에 도달하기 전에 오버슈팅(over-shooting)할 수 있고, 너무 작으면 수렴하는 데 시간이 오래 걸립니다.

- 기울기: 기울기는 특정 지점에서 함수의 변화율을 나타내며, 비용 함수의 기울기가 크면 더 빠르게 최적화되고, 기울기가 작으면 최적화 속도가 느려집니다.

2. 2차 함수에서 기울기 0의 의미 (미분을 통해 기울기 0이 되는 극값, 모델의 최적화)

- 답변: 경사하강법에서 2차 함수의 기울기가 0이라는 것은 해당 지점이 극값(extremum)에 도달했다는 것을 의미합니다. 구체적으로 2차 함수에서는 기울기가 0인 지점이 최소점(혹은 최대점)으로, 더 이상 비용 함수를 줄일 수 없는 최적화된 상태입니다. 예를 들어, 함수 f(x)=ax2+bx+cf(x) = ax^2 + bx + cf(x)=ax2+bx+c에서 미분을 통해 기울기가 0이 되는 지점 x=−b2ax = -\frac{b}{2a}x=−2ab를 구할 수 있으며, 이 지점은 최소점일 가능성이 높습니다. 경사하강법에서 이 지점에 도달하면 모델이 최적화되었다고 할 수 있습니다.

구체적 예시:

- 2차 함수 f(x)=x2f(x) = x^2f(x)=x2에서 경사하강법을 적용하면, 기울기가 0인 지점 x=0x = 0x=0에서 함수의 최솟값에 도달하게 됩니다. 즉, 경사하강법은 함수의 기울기가 0이 되는 지점까지 이동하며, 그 지점에서 더 이상 이동하지 않게 됩니다.

3. 경사하강법의 응용

- 답변: 경사하강법은 주로 머신러닝에서 모델의 매개변수(가중치와 편향)를 학습할 때 사용됩니다. 예를 들어, 선형 회귀에서 비용 함수로 주어진 평균 제곱 오차(Mean Squared Error)를 최소화하기 위해 경사하강법을 사용하여 모델의 가중치를 업데이트합니다. 학습 과정에서 매개변수가 조금씩 조정되면서 오차가 점점 줄어들고, 최종적으로 최적의 가중치 값을 얻게 됩니다.

- 또한 딥러닝에서 경사하강법은 신경망의 가중치를 학습하는 데 사용됩니다. 이때, 역전파 알고리즘과 함께 경사하강법이 작동하여 가중치가 업데이트됩니다.

3. 확률과 통계 질문

- 예상 질문: 확률 분포, 통계적 추론 또는 랜덤 포레스트와 같은 알고리즘에서 사용되는 통계 개념을 설명할 수 있는가?

- 준비 방법: 기본적인 확률 분포, 통계적 추론, 그리고 랜덤 포레스트와 같은 데이터 분석 알고리즘에서의 확률 개념을 숙지하세요. 이 알고리즘이 어떻게 데이터를 분류하고 예측하는지 설명할 수 있어야 합니다

-

예상 질문:

- 확률 분포와 그 응용에 대해 설명할 수 있는가?

- 통계적 추론이란 무엇이며, 이를 데이터 분석에서 어떻게 사용하는가?

- 랜덤 포레스트에서 확률 개념이 어떻게 사용되는가?

1. 확률 분포의 개념

- 답변: 확률 분포는 어떤 사건의 발생 가능성을 설명하는 함수입니다. 확률 분포에는 이산 확률 분포와 연속 확률 분포가 있습니다. 예를 들어, 동전을 던지는 실험에서는 이산 확률 분포를, 사람들의 키와 같은 연속적인 데이터를 다룰 때는 연속 확률 분포를 사용합니다.

- 이산 확률 분포: 특정 사건이 발생할 확률을 나타냅니다. 대표적으로 이항 분포와 포아송 분포가 있습니다. 이항 분포는 성공/실패처럼 두 가지 결과만 있는 실험에서 사용되고, 포아송 분포는 특정 시간 동안 사건이 발생하는 횟수를 모델링할 때 사용됩니다.

- 연속 확률 분포: 특정 구간 내에서 변수가 가질 수 있는 값들의 확률을 나타냅니다. 정규 분포가 가장 많이 사용되며, 이는 종 모양의 대칭적 곡선으로 나타낼 수 있습니다. 평균과 표준 편차를 이용해 데이터의 분포를 설명합니다.

예시: 학생들의 시험 점수를 분석할 때, 점수들이 정규 분포를 따를 가능성이 큽니다. 정규 분포를 통해 평균 근처에 많은 학생들이 분포하고, 극단적인 점수를 받은 학생은 적다는 것을 알 수 있습니다.

2. 통계적 추론

- 답변: 통계적 추론은 표본 데이터를 바탕으로 모집단의 특성을 추정하거나 가설을 검정하는 방법입니다. 통계적 추론에는 추정과 가설 검정이 포함됩니다.

- 추정: 표본의 평균, 분산 등을 이용하여 모집단의 평균이나 분산을 추정하는 방법입니다. 점추정(point estimation)과 구간추정(interval estimation)이 있으며, 구간추정은 표본 데이터를 바탕으로 모집단 특성의 범위를 추정합니다.

- 가설 검정: 통계적 가설을 세우고, 표본 데이터를 이용해 이를 검정하는 과정입니다. p-value를 사용하여 가설이 참일 가능성을 평가하며, 일반적으로 p-value가 0.05 이하일 경우 가설을 기각합니다.

예시: 특정 신약의 효과를 검증할 때, 통계적 추론을 사용하여 약물 실험의 결과를 바탕으로 모집단에서 신약이 효과적인지 여부를 추정할 수 있습니다.

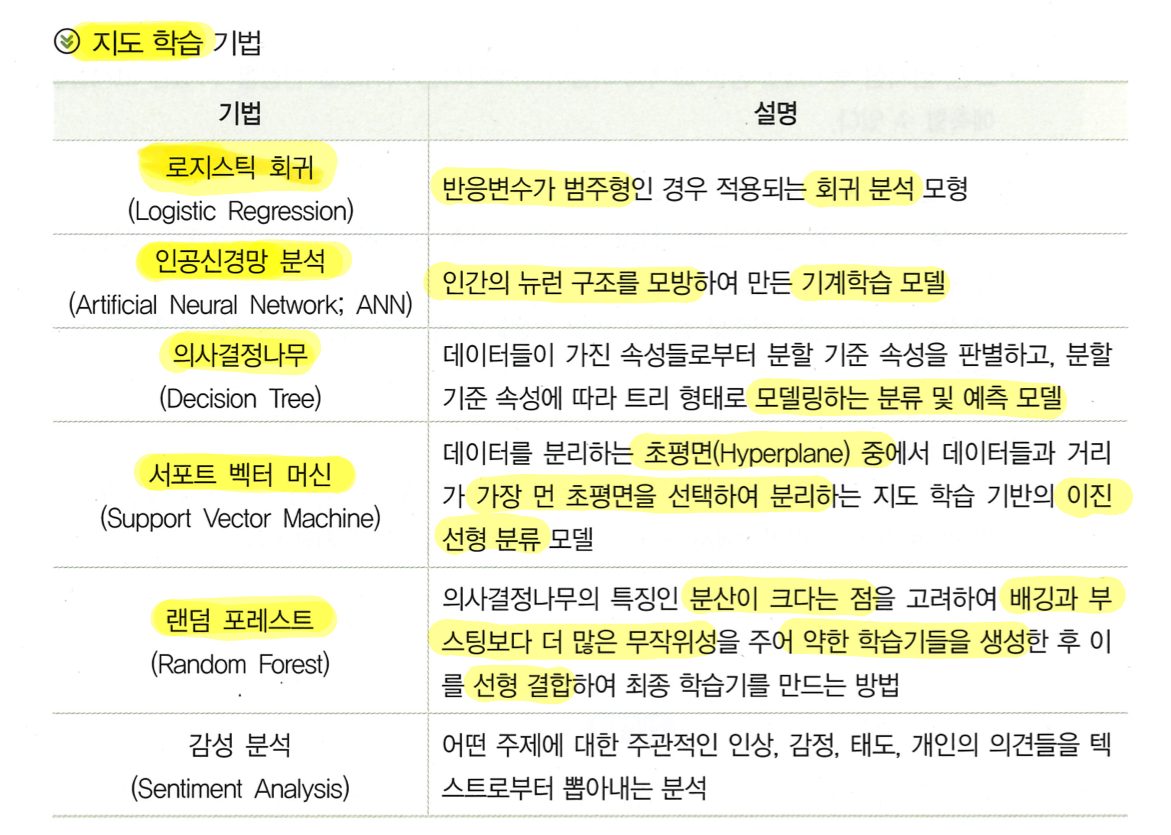

3. 랜덤 포레스트(Random Forest)와 확률 개념

- 답변: 랜덤 포레스트(Random Forest)는 여러 개의 결정 트리(decision tree)를 결합하여 예측의 정확성을 높이는 앙상블 학습 방법입니다. 각 트리는 서로 다른 데이터 샘플을 이용하여 학습하며, 최종 예측은 각 트리의 예측 결과를 종합하여 결정됩니다.

- 랜덤 포레스트에서 확률 개념은 각 트리의 예측 결과가 확률적으로 기여하는 방식으로 작동합니다. 즉, 분류 문제에서는 여러 트리가 서로 다른 클래스를 예측할 수 있으며, 최종 예측은 각 클래스가 예측될 확률에 따라 결정됩니다.

- 예를 들어, 100개의 트리 중 70개가 클래스 A를 예측하고, 30개가 클래스 B를 예측했다면, 클래스 A가 최종 예측 값이 될 확률이 높습니다.

응용 예시: 랜덤 포레스트는 고객 이탈 예측과 같은 분류 문제에서 사용됩니다. 예를 들어, 고객의 과거 행동 데이터를 바탕으로 여러 결정 트리를 학습시키고, 트리들의 다수결로 고객이 이탈할 확률을 예측할 수 있습니다.

앙상블 모델의 주요 유형

앙상블 모델은 모델들을 결합하는 방식에 따라 다양한 종류가 있습니다.

1. 배깅(Bagging, Bootstrap Aggregating)

배깅은 여러 개의 학습 데이터 세트를 무작위로 생성하고, 각각의 모델을 학습시킨 후 그 결과를 결합하는 방법입니다. 보통 다수결 방식(분류 문제)이나 평균(회귀 문제)을 사용해 최종 예측을 결정합니다.

- 예시: 대표적인 배깅 모델로 **랜덤 포레스트(Random Forest)**가 있습니다. 여러 개의 의사결정 나무(Decision Tree)를 학습하고 그 결과를 결합하여 더 나은 예측을 제공합니다.

2. 부스팅(Boosting)

부스팅은 여러 모델을 순차적으로 학습시키는 방식입니다. 이전 모델이 잘못 예측한 부분에 집중하여 새로운 모델을 학습시키는 과정이 반복됩니다. 이렇게 하면 각 모델이 이전 모델의 실수를 보완하면서 성능을 향상시킵니다.

- 예시: Gradient Boosting이나 XGBoost가 부스팅 기법의 대표적인 알고리즘입니다. 이들은 매우 강력한 성능을 보여주는 알고리즘입니다.

3. 스태킹(Stacking)

스태킹은 여러 개의 모델을 학습시키고, 그 결과를 결합하여 최종 예측을 내리는 방식입니다. 배깅과 부스팅과 달리, 스태킹은 각 모델의 결과를 단순히 결합하는 것이 아니라, 또 다른 모델(메타 모델)이 이들 결과를 기반으로 최종 결정을 내립니다.

- 예시: 여러 다른 유형의 모델(예: SVM, 랜덤 포레스트, 로지스틱 회귀 등)을 결합한 후, 그 결과를 종합해 새로운 모델로 최종 결정을 내릴 수 있습니다.

4. 보팅(Voting)

보팅은 여러 개의 모델이 각기 다른 예측을 제공할 때, 다수결 투표를 통해 최종 결과를 결정하는 방식입니다. 분류 문제에서 자주 사용되며, 각 모델의 예측 결과에서 가장 많이 등장한 클래스를 최종 결과로 선택합니다.

- 하드 보팅: 다수결 방식으로 결과를 결정.

- 소프트 보팅: 각 모델의 예측 확률을 평균 내어 결과를 결정.

이 질문들에 대한 답변을 준비할 때는 이론적인 설명과 함께 실제 응용 사례를 들어 설명하는 것이 중요합니다. 예를 들어, 랜덤 포레스트의 작동 원리와 이를 통해 얻어진 확률적 예측 결과가 어떤 식으로 의사결정에 도움을 주는지를 설명하면 좋습니다.

4. 수학적 개념의 응용

- 예상 질문: 미분, 적분의 응용 사례를 알고 있는가? 기울기, 함수의 극값 등 데이터 분석에서의 수학적 개념의 응용을 설명할 수 있는가?

- 준비 방법: 미적분의 기본 개념을 데이터 분석에 어떻게 적용할 수 있는지, 특히 머신러닝에서 기울기, 최적화 문제, 극값을 찾는 방법 등을 설명할 수 있도록 준비하세요

- 예상 질문:

- 미분과 적분의 응용 사례를 알고 있는가?

- 데이터 분석에서 기울기와 함수의 극값이 어떤 역할을 하는지 설명할 수 있는가?

1. 미분과 적분의 응용

- 답변: 미분과 적분은 수학의 기본 개념으로, 데이터 분석과 머신러닝에서 중요한 역할을 합니다.

- 미분: 함수의 기울기 또는 변화율을 계산하는 과정입니다. 예를 들어, 머신러닝에서 비용 함수를 최소화할 때, 기울기가 가장 작은 지점을 찾는 데 미분이 사용됩니다. 이를 통해 가중치의 업데이트 방향을 결정할 수 있습니다. 구체적으로, 경사하강법에서 비용 함수의 미분 값이 사용됩니다.

- 적분: 적분은 누적된 값을 계산하는 데 사용됩니다. 예를 들어, 누적 확률을 계산하거나, 특정 구간에서의 면적을 구할 때 활용됩니다. 물리학적 모델링이나 경제학에서 누적 성장률을 계산하는 데 자주 사용됩니다.

응용 예시: 적분은 연속적인 데이터의 면적을 계산하는 데 사용됩니다. 예를 들어, 특정 시간 동안의 총 누적 판매량을 예측하거나, 경제 모델에서 변화량을 측정할 수 있습니다.

2. 기울기와 극값의 의미

- 답변: 기울기는 함수가 변화하는 방향과 속도를 나타냅니다. 데이터 분석에서 기울기는 최적화 문제를 해결할 때 중요한 역할을 합니다. 예를 들어, 머신러닝에서 기울기는 가중치가 업데이트될 방향을 결정하는데 사용되며, 기울기가 큰 곳에서는 더 빠르게, 작은 곳에서는 더 천천히 변화합니다.

- 극값: 함수의 극값은 미분을 통해 기울기가 0인 지점을 찾아서 확인할 수 있습니다. 이 극값은 함수가 최솟값 또는 최댓값을 갖는 지점입니다. 데이터 분석에서는 비용 함수의 극소점을 찾아 모델을 최적화합니다. 즉, 비용 함수의 기울기가 0이 되는 지점에서 비용이 최소화되고, 이는 최적의 가중치로 이어집니다.

응용 예시: 예를 들어, 선형 회귀 모델에서 최적의 가중치를 찾기 위해 비용 함수의 기울기가 0이 되는 지점을 찾습니다. 이 지점에서 모델의 예측 오차가 최소화됩니다. 이는 머신러닝에서 모델을 학습시키는 과정의 핵심입니다.

3. 기울기와 경사하강법의 연관성

- 답변: 경사하강법은 미분을 사용하여 비용 함수의 기울기를 계산하고, 이 기울기의 반대 방향으로 가중치를 업데이트하여 함수의 최솟값에 도달합니다. 경사하강법은 기울기가 0이 되는 지점을 찾기 위해 반복적으로 가중치를 조정하며, 이 과정에서 극값을 찾게 됩니다.

예시: 머신러닝 모델을 훈련할 때, 비용 함수의 기울기를 계산하고 가중치를 업데이트하는 것이 경사하강법의 핵심입니다. 이를 통해 모델은 점점 최적의 성능에 도달하게 됩니다.

이 질문에 대비할 때, 미적분의 이론적 개념뿐 아니라 데이터 분석 및 머신러닝에서의 실제 응용 사례를 함께 설명하는 것이 중요합니다. 예를 들어, 머신러닝에서 기울기를 계산하고, 그 기울기가 0이 되는 지점에서 비용을 최소화하는 경사하강법의 작동 원리를 설명할 수 있어야 합니다.

5. 머신러닝 모델의 수학적 기초

예상 질문:

- 머신러닝 모델의 수학적 기초에 대해 설명할 수 있는가?

- 선형 회귀, 로지스틱 회귀 등의 기본 모델에서 수학적 원리를 알고 있는가?

- 머신러닝에서 최적화 문제를 해결하기 위한 수학적 방법이 무엇인가?

1. 머신러닝 모델의 수학적 기초

- 답변: 머신러닝 모델은 주로 선형대수, 미적분, 확률론과 같은 수학적 기초 위에 세워집니다. 모델이 데이터를 기반으로 학습하고 최적화하는 과정에서 수학은 중요한 역할을 합니다. 예를 들어, 선형 회귀는 데이터를 바탕으로 최적의 직선을 찾기 위해 미분을 사용하여 손실 함수(loss function)를 최소화하는 과정입니다. 또한, 로지스틱 회귀에서는 시그모이드 함수(sigmoid function)를 사용해 확률 값을 출력하고, 손실 함수는 로그 우도 함수(log-likelihood)를 기반으로 최적화됩니다.

예시: 선형 회귀의 목표는 주어진 데이터에 가장 적합한 직선을 찾는 것이며, 이를 위해 **평균 제곱 오차(MSE)**를 최소화하는 것이 핵심입니다. MSE를 미분하여 기울기를 계산하고, 경사하강법을 통해 가중치를 조정하여 최적의 직선을 찾습니다.

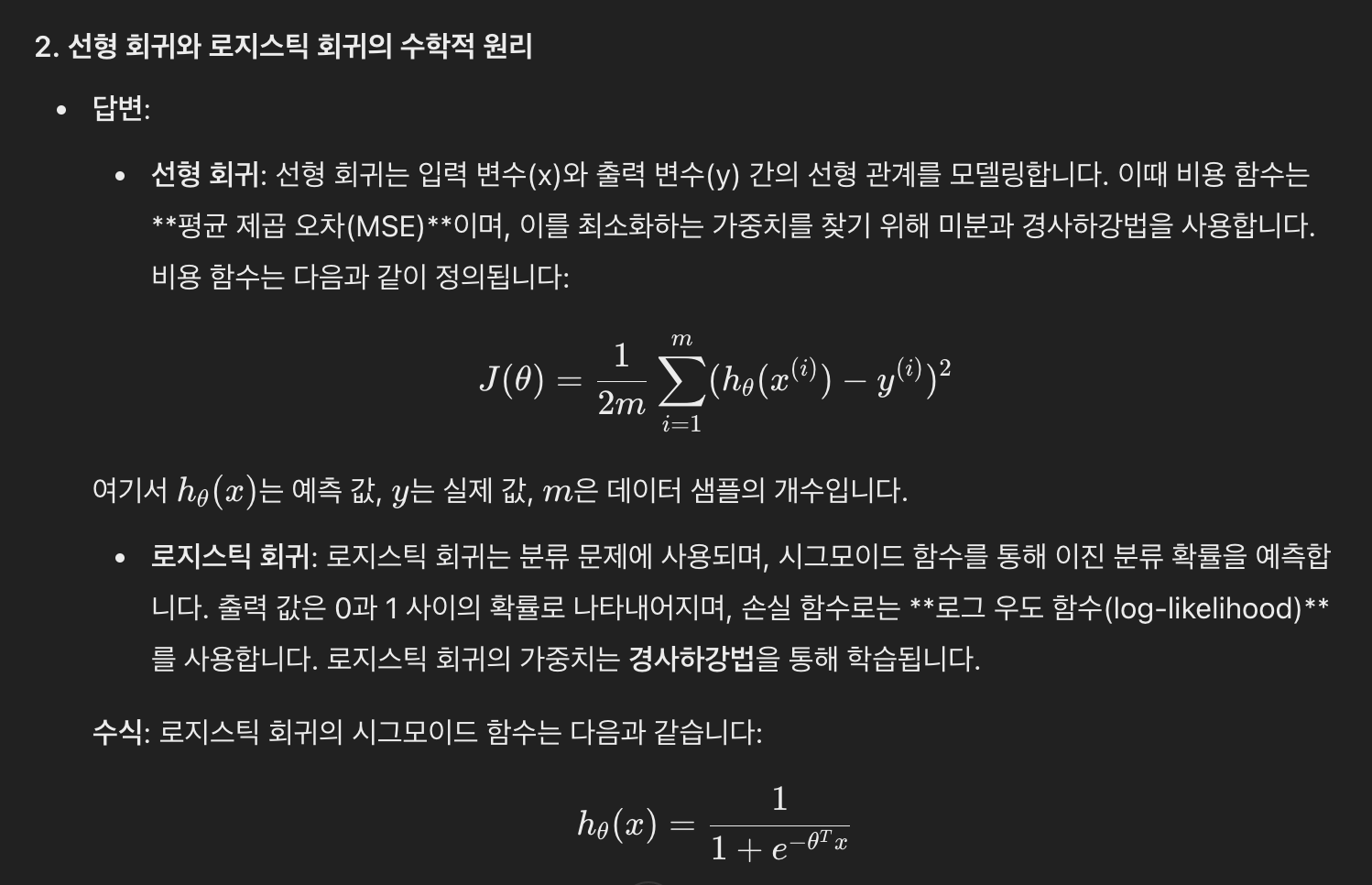

2. 선형 회귀와 로지스틱 회귀의 수학적 원리

-

- 선형 회귀: 선형 회귀는 입력 변수(x)와 출력 변수(y) 간의 선형 관계를 모델링합니다.

- 이때 비용 함수는 평균 제곱 오차(MSE) 이며, 이를 최소화하는 가중치를 찾기 위해 미분과 경사하강법을 사용합니다.

- 로지스틱 회귀: 로지스틱 회귀는 분류 문제에 사용되며, 시그모이드 함수를 통해 이진 분류 확률을 예측합니다.

- 출력 값은 0과 1 사이의 확률로 나타내어지며, 손실 함수로는 로그 우도 함수(log-likelihood)를 사용합니다.

- 로지스틱 회귀의 가중치는 경사하강법을 통해 학습됩니다.

3. 최적화 문제 해결을 위한 수학적 방법

- 답변: 머신러닝 모델을 훈련할 때 주요 목표는 최적화입니다. 이 과정에서 경사하강법(Gradient Descent)과 같은 알고리즘이 많이 사용됩니다. 경사하강법은 비용 함수의 기울기를 계산하여, 함수의 값을 최소화하는 방향으로 가중치를 업데이트합니다. 또한, 확률적 경사하강법(Stochastic Gradient Descent, SGD)은 데이터를 샘플 단위로 처리하여 계산을 빠르게 하고, 대규모 데이터셋에서도 효과적으로 작동합니다.

추가적인 최적화 방법:

- 배치 경사하강법: 전체 데이터셋을 한 번에 처리하여 가중치를 업데이트합니다.

- 확률적 경사하강법(SGD): 하나의 데이터 샘플을 사용하여 반복적으로 업데이트하며, 빠른 계산이 가능하지만 노이즈가 있을 수 있습니다.

- 모멘텀(Momentum): 경사하강법의 수렴 속도를 높이기 위해, 이전 기울기의 정보를 반영하여 가중치를 조정하는 기법입니다.

4. 머신러닝에서 확률 개념의 응용

- 답변: 머신러닝 모델에서 확률론은 불확실성을 다룰 때 사용됩니다.

- 예를 들어, 로지스틱 회귀나 Naive Bayes 모델은 확률을 기반으로 하여 예측을 수행합니다.

- Naive Bayes는 베이즈 정리를 이용하여 클래스에 속할 확률을 계산하고, 가장 높은 확률을 가진 클래스를 예측합니다.

예시: Naive Bayes 분류기는 사전 확률(prior probability)과 가능도(likelihood)를 이용해 새로운 데이터가 주어졌을 때 어느 클래스에 속할 확률이 높은지 계산합니다.

이 질문에 답변할 때는 수학적 원리뿐만 아니라 실제 머신러닝 모델에서의 응용 사례도 설명할 수 있도록 준비하는 것이 중요합니다. 예를 들어, 선형 회귀와 로지스틱 회귀에서의 수학적 최적화 과정을 설명하고, 경사하강법이 어떻게 학습 과정에 적용되는지를 구체적으로 답변하면 면접에서 좋은 인상을 줄 수 있습니다.

머신러닝(Machine Learning) vs 딥러닝(Deep Learning)

1. 개념

- 머신러닝(Machine Learning): 머신러닝은 데이터에서 학습하여 명시적인 프로그래밍 없이 특정 작업을 수행할 수 있는 알고리즘을 개발하는 기술입니다. 주어진 데이터에서 패턴을 찾아내고 그 패턴을 바탕으로 예측을 하는 것이 주목적입니다. 머신러닝 알고리즘은 데이터를 기반으로 규칙이나 모델을 학습한 후, 새로운 데이터에 대해 예측을 수행합니다.

- 딥러닝(Deep Learning): 딥러닝은 인공 신경망(Artificial Neural Networks)을 기반으로 하는 머신러닝의 하위 분야입니다. 딥러닝은 여러 개의 층(layer)으로 구성된 신경망을 통해 데이터의 추상화된 특징을 학습합니다. 복잡한 데이터에서 패턴을 발견하고 이를 바탕으로 더 정교한 예측을 할 수 있습니다. 딥러닝은 대규모 데이터와 고성능 컴퓨팅 자원을 사용해 뛰어난 성능을 발휘합니다.

2. 알고리즘 구조

- 머신러닝: 머신러닝은 다양한 알고리즘을 포함합니다. 대표적인 알고리즘으로는 의사결정 나무(Decision Trees), 서포트 벡터 머신(SVM), k-평균 군집화(k-Means Clustering), 회귀 분석(Regression) 등이 있습니다. 이 알고리즘은 보통 사람이 직접 설계한 특징(feature)을 사용하여 데이터를 분석하고 예측합니다.

- 딥러닝: 딥러닝에서는 다층 신경망(Multi-layer Neural Networks)을 사용합니다. 입력층(Input Layer), 출력층(Output Layer), 그리고 여러 개의 숨겨진 층(Hidden Layers)으로 구성된 신경망 구조를 통해 데이터를 처리합니다. 딥러닝에서는 자동으로 특징을 학습하므로 사람이 직접 특징을 설계할 필요가 없습니다. 특히 딥러닝에서는 컨볼루션 신경망(CNN), 순환 신경망(RNN)과 같은 심화된 모델들이 사용됩니다.

3. 학습 방식

- 머신러닝: 머신러닝에서는 대부분 사람이 데이터를 분석하고 특징을 추출(feature extraction)하여 알고리즘이 학습할 수 있도록 합니다. 이 과정에서 전문가의 지식이 많이 요구됩니다. 머신러닝은 지도 학습(Supervised Learning), 비지도 학습(Unsupervised Learning), 강화 학습(Reinforcement Learning) 등 다양한 학습 방식이 있습니다.

- 딥러닝: 딥러닝에서는 데이터의 자동 특징 추출이 가능합니다. 즉, 사람이 직접 특징을 정의하지 않아도 신경망이 다층 구조를 통해 데이터를 점점 더 추상화된 형태로 변환하면서 중요한 특징을 스스로 학습합니다. 이는 대규모 데이터에서 특히 효과적이며, 이미지 인식, 음성 인식, 자연어 처리와 같은 복잡한 작업에 뛰어난 성능을 발휘합니다.

4. 데이터 요구 사항

- 머신러닝: 머신러닝 알고리즘은 적은 양의 데이터로도 학습할 수 있습니다.

- 작은 데이터셋으로도 성능이 좋은 모델을 만들 수 있으며, 주로 정형 데이터(Structured Data)에 잘 맞습니다.

- 딥러닝: 딥러닝은 대규모 데이터셋(Big Data)에서 강력한 성능을 발휘합니다.

- 특히 이미지, 음성, 텍스트와 같은 비정형 데이터(Unstructured Data)에 적합하며, 학습을 위해 많은 데이터를 필요로 합니다. 적은 데이터로는 과적합(overfitting) 문제에 취약할 수 있습니다.

6. 적용 사례

- 머신러닝: 머신러닝은 금융 서비스(신용 평가, 사기 탐지), 의료(질병 예측), 마케팅(추천 시스템), 제조업(수요 예측) 등 다양한 분야에서 사용됩니다. 머신러닝은 비교적 단순한 데이터 분석과 예측 작업에서 많이 활용됩니다.

- 딥러닝: 딥러닝은 이미지 인식, 음성 인식, 자연어 처리(NLP), 자율주행차, 번역 시스템 등에서 활발히 사용됩니다. 특히 복잡한 문제를 해결하고 고도의 예측을 수행하는 작업에 적합합니다.

요약:

- 머신러닝: 데이터를 기반으로 예측 및 분류를 수행하는 알고리즘. 사람이 직접 특징을 추출하여 학습에 사용하며, 적은 데이터와 비교적 적은 계산 자원으로도 좋은 성능을 낼 수 있음.

- 딥러닝: 인공 신경망을 사용한 머신러닝의 하위 분야. 대규모 데이터를 자동으로 학습하여 복잡한 문제를 해결하며, 높은 연산 자원과 대규모 데이터셋을 필요로 함.

② Decision Tree와 Random Forest의 차이점은?

- Decision Tree: 하나의 트리로 데이터를 분류하거나 예측하는 모델입니다. 노드에서 데이터가 분기되면서 학습이 이루어지며, 단순하지만 과적합(overfitting)이 발생하기 쉽습니다.

- Random Forest: 여러 개의 Decision Tree를 합친 앙상블 모델로, 각각의 트리가 독립적으로 학습한 후 다수결 투표를 통해 최종 예측값을 결정합니다. 과적합을 방지하고, 예측 성능을 향상시키는 효과가 있습니다.

③ 업무 중 Regression을 활용해본 경험이 있는지, 있다면 어떻게 활용하였는지?

Regression(회귀)을 활용한 경험은 있습니다. 예를 들어, 소득 데이터를 기반으로 특정 패턴을 예측하거나, 복합적인 변수를 이용해 집값을 예측하는 업무에서 선형 회귀(Linear Regression)를 사용해 각 변수들이 결과에 미치는 영향을 분석하였습니다. 이러한 회귀 분석을 통해 데이터를 기반으로 의사결정을 지원할 수 있었습니다.

④ 최근 코딩으로 만들어봤던 알고리즘은 어떤 것인지?

최근에는 중복 지급 탐지 AI 모델 개발 프로젝트에서 데이터를 효과적으로 분류하기 위해 k-means 클러스터링 알고리즘을 사용했습니다. 이를 통해 비슷한 데이터의 군집을 파악하고, 중복 패턴을 감지하는 데 활용하였습니다. 또한, Python을 사용하여 대량의 데이터를 전처리하고 분석하는 과정을 수행했습니다.

⑤ 비선형 모델은 어떤 것이 적합한지?

비선형 모델로는 **Support Vector Machine(SVM)**이나 Neural Networks(신경망) 모델이 적합합니다. 특히, 복잡한 패턴이나 비선형적인 데이터 관계를 모델링할 때 신경망은 매우 유용합니다. 또한 Decision Tree 기반의 **Gradient Boosting Machine(GBM)**과 같은 모델도 비선형 데이터를 다루는 데 효과적입니다.

⑥ 모델링 중 과적합이 발생할 경우 주로 어떤 방법으로 해결하는지?

과적합을 해결하는 방법으로는 주로 아래와 같은 방법들을 사용합니다:

- Cross-validation: 데이터를 훈련, 검증, 테스트로 나눠 모델이 훈련 데이터에만 의존하지 않도록 합니다.

- Regularization: L1, L2 정규화 기법을 사용하여 모델의 복잡도를 줄입니다.

- Pruning: Decision Tree 모델에서는 가지치기를 통해 과적합을 방지합니다.

- Dropout: 신경망 모델에서는 학습 중 일부 노드를 무작위로 끄는 Dropout 기법을 사용해 과적합을 방지합니다.

- 앙상블 기법: 여러 모델을 결합해 성능을 향상시키고, 과적합을 완화합니다.

- 리스트, 튜플, 딕셔너리 차이

리스트(List), 튜플(Tuple), 딕셔너리(Dictionary)는 파이썬에서 사용하는 대표적인 자료형으로, 다음과 같은 차이점이 있습니다.

1. 리스트(List):

• 가변성: 리스트는 가변형(mutable) 자료형으로, 생성 후에도 요소를 추가, 삭제, 수정할 수 있습니다.

• 중복 허용: 리스트는 중복된 값을 가질 수 있습니다.

• 순서가 있는 데이터 구조: 리스트는 순서가 있는 자료형으로, 요소의 순서가 유지됩니다.

• 사용 예: [1, 2, 3, 4], ['apple', 'banana', 'cherry']

• 기본 기능: 요소의 인덱싱, 슬라이싱, 반복, 정렬, 추가/삭제 등이 가능합니다.

2. 튜플(Tuple):

• 불변성: 튜플은 불변형(immutable) 자료형으로, 생성 후 수정이 불가능합니다.

• 중복 허용: 리스트와 마찬가지로 중복된 값을 가질 수 있습니다.

• 순서가 있는 데이터 구조: 튜플도 순서가 있는 자료형으로, 요소의 순서가 유지됩니다.

• 사용 예: (1, 2, 3, 4), ('apple', 'banana', 'cherry')

• 기본 기능: 요소의 인덱싱, 슬라이싱, 반복이 가능하나, 수정이나 삭제는 불가능합니다.

3. 딕셔너리(Dictionary):

• 가변성: 딕셔너리는 가변형(mutable) 자료형으로, 생성 후 요소를 추가, 삭제, 수정할 수 있습니다.

• 중복 불허: 딕셔너리는 **키(key)**가 중복될 수 없습니다. 즉, 같은 키를 여러 번 사용할 수 없으며, 중복된 키를 넣으면 마지막에 추가된 값이 저장됩니다.

• 순서가 없는 데이터 구조(파이썬 3.6 이전): 파이썬 3.7부터는 삽입 순서를 유지하지만, 일반적으로 키-값 쌍의 순서가 중요하지 않습니다.

• 키-값 쌍: 딕셔너리는 키와 그에 대응하는 값으로 이루어져 있으며, 키를 사용해 값을 검색합니다.

• 사용 예: {'name': 'Alice', 'age': 25, 'city': 'New York'}

• 기본 기능: 키를 통해 값에 접근, 추가, 삭제가 가능하며, 키나 값을 기준으로 반복 작업도 가능합니다.

요약:

• 리스트: 가변형, / 순서 있음, 중복 허용.

• 튜플: 불변형, / 순서 있음, 중복 허용.

• 딕셔너리: 가변형, / 순서 없음(3.7부터는 순서 유지), 키-값 구조, 중복 키 불허

각 자료형은 특정 상황에 맞춰 사용하면 성능과 코드 가독성을 높이는 데 유용합니다.

'전산 관련 시험 > PT, 토론, 전공, 인성 면접 대비' 카테고리의 다른 글

| 디지털/IT_토론면접 (0) | 2023.04.14 |

|---|---|

| 전산 직무/인성 면접 (0) | 2023.04.12 |

| 직무, 인성, PT 면접 대비 (종합역량) (0) | 2023.04.08 |

| 전체 면접 리스트 정리(직무, 인성 포함) (0) | 2023.04.03 |

| 인성면접 질문 리스트 (0) | 2023.04.03 |

댓글