앙상블 기법

: 주어진 자료로부터 여러개의 예측모형을 만든 후 예측 모형들을 조합하여 하나의 최종 예측모형을 만드는 방법

ex) 배깅, 부스팅, 랜덤포레스트(배깅과 임의선택을 결합한 앙상블 방법)

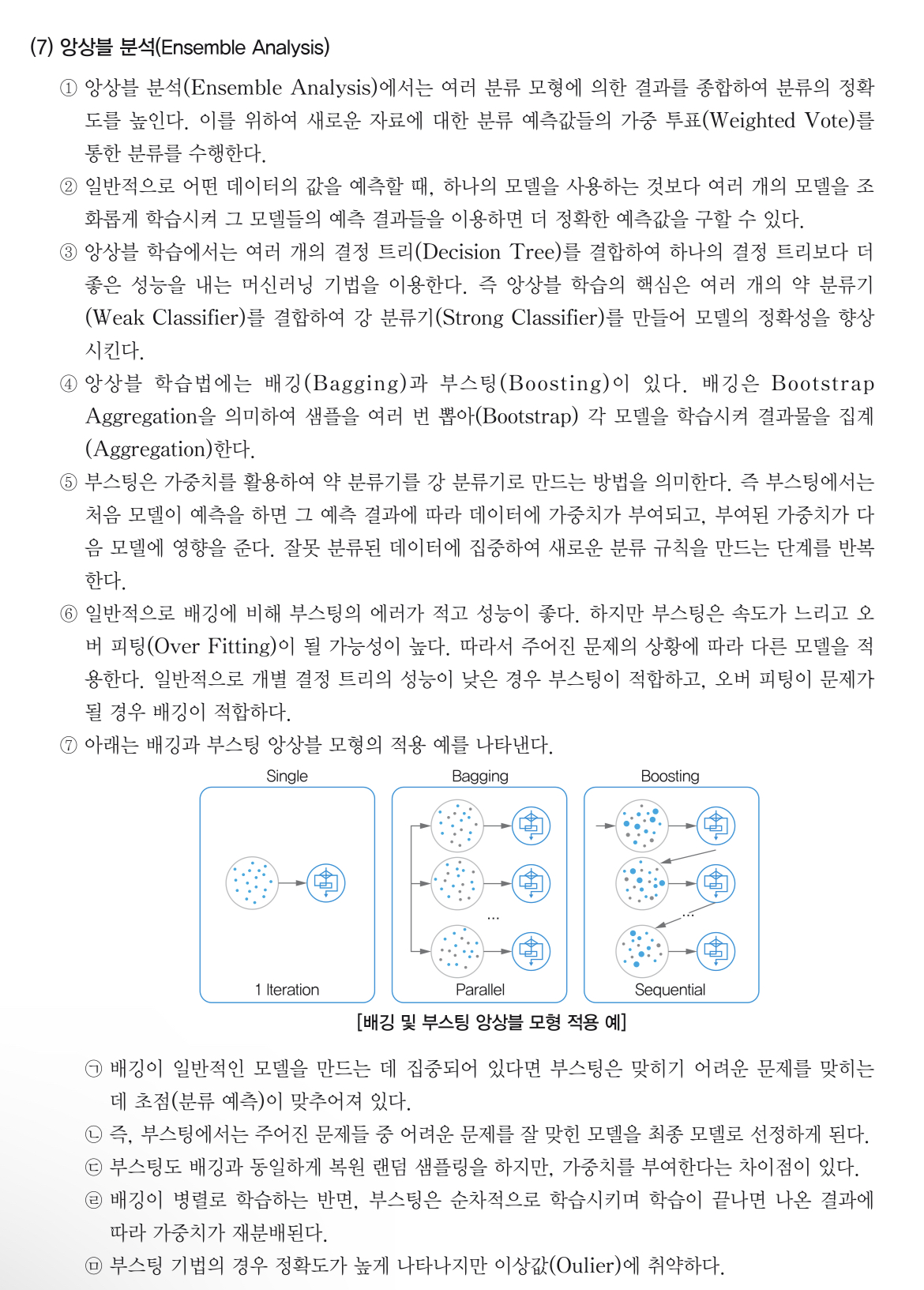

1) 배깅(Bagging)

: 주어진 자료에서 여러개의 부스트랩 자료를 생성하고, 각 붓스트랩 자료에 예측모형을 만든 후 결합하여 최종 예측모형을 만드는 방법

- 샘플을 여러 번 뽑아 학습시킨 모델들의 결과물을 집계하여 결과값 출력

- 서로 같은 알고리즘 투표

- Bootstrap Aggregation의 약자

보팅(Voting)

: 여러 개의 모형으로부터 산출된 결과를 다수결에 의해서 최종 결과를 선정하는 과정

- 서로 다른 알고리즘 투표

2) 부스팅(Boosting)

: 예측력이 약한 모형들을 결합하여 강한 예측 모형을 만드는 방법으로 오분류 데이터에 가중치를 부여하는 방법

- 이전 모델의 학습결과에 따른 가중치를 데이터에 부여함

- 배깅은 일반적인 모델을 만드는데 집중하는 반면, 부스팅은 맞히기 어려운 문제를 맞추는데 초점을 두고 있음

- 잘못 예측한 데이터에 가중치를 부여하여 오류를 개선해나감며 학습하는 방식

3) 랜덤포레스트(Random Forest)

: 의사결정나무의 특징인 분산이 크다는 점을 고려하여, 배깅과 부스팅보다 더 많은 무작위성을 주어 여러개의 약한 학습기를 생성하고, 이를 결합해 최종적으로 종속변수를 분류하거나 예측

- 트리의 다양성을 극대화하여 예측력이 우수하고 많은 트리의 예측 결과를 종합하기 때문에 안정성이 높다.

http://www.dinnopartners.com/__trashed-4/

머신러닝 앙상블(Ensemble) 학습 – DINNO PARTNERS

1. 앙상블 학습이란? 앙상블 학습(Ensemble Learning)은 여러 개의 분류기를 생성하고, 그 예측을 결합함으로써 보다 정확한 예측을 도출하는 기법을 말합니다. 강력한 하나의 모델을 사용하는대신 보

www.dinnopartners.com

- 보팅(Voting)

- 여러 개의 분류기가 투표를 통해 최종 예측 결과를 결정하는 방식

- 서로 다른 알고리즘을 여러 개 결합하여 사용

- 보팅 방식

- 하드 보팅(Hard Voting)

- 다수의 분류기가 예측한 결과값을 최종 결과로 선정

- 소프트 보팅(Soft Voting)

- 모든 분류기가 예측한 레이블 값의 결정 확률 평균을 구한 뒤 가장 확률이 높은 레이블 값을 최종 결과로 선정

- 하드 보팅(Hard Voting)

- 배깅(Bootstrap AGGregatING, Bagging)

- 데이터 샘플링(Bootstrap) 을 통해 모델을 학습시키고 결과를 집계(Aggregating) 하는 방법

- 모두 같은 유형의 알고리즘 기반의 분류기를 사용

- 데이터 분할 시 중복을 허용

- Categorical Data : 다수결 투표 방식으로 결과 집계

- Continuous Data : 평균값 집계

- 과적합(Overfitting) 방지에 효과적

- 대표적인 배깅 방식 : 랜덤 포레스트 알고리즘

- 부스팅(Boosting)

- 여러개의 분류기가 순차적으로 학습을 수행

- 이전 분류기가 예측이 틀린 데이터에 대해서 올바르게 예측할 수 있도록 다음 분류기에게 가중치(weight)를 부여하면서 학습과 예측을 진행

- 계속하여 분류기에게 가중치를 부스팅하며 학습을 진행하기에 부스팅 방식이라고 불림

- 예측 성능이 뛰어나 앙상블 학습을 주도

- 대표적인 부스팅 모듈 – XGBoost, LightGBM

- 보통 부스팅 방식은 배깅에 비해 성능이 좋지만, 속도가 느리고 과적합이 발생할 가능성이 존재하므로 상황에 따라 적절하게 사용해야 함.

'전산 관련 시험 > 빅데이터분석기사, AI 용어' 카테고리의 다른 글

| 지도학습 - 로지스틱 회귀분석 (0) | 2022.09.29 |

|---|---|

| 확률분포 - 포아송분포 (1) | 2022.09.29 |

| 개인정보, 가명정보, 익명정보 (0) | 2022.09.29 |

| 머신러닝 데이터 모델링 방법 - 지도학습, 비지도학습, 강화학습 (0) | 2022.09.29 |

| 데이터 종류 - 정형 데이터, 반정형 데이터, 비정형 데이터 (0) | 2022.09.26 |

댓글