CNN : 합성곱 신경

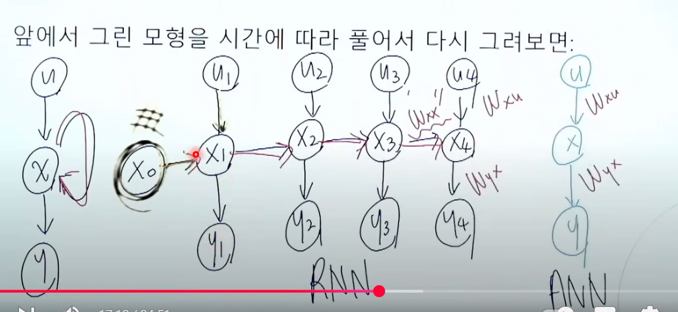

RNN : 시계열 데이터를 처리하기에 좋은 뉴럴 네트워크 구조

First Order System : 현재 시간의 상태가 이전 시간의 상태와 관련이 있따고 가정

X0 - X1 - X2 - X3 ...

외부 입력 없이 자기 혼자 돌아가는 시스템

입력 있을 경우 : 현재 시간의 상태가 이전 시간의 상태와, 현재의 입력에 관계가 있는 경우

State-Space Model

관측 가능한 상태의 모음 : 출력

어떤 시스템을 해석하기 위한 3요소 : 입력, 상태, 출력

ANN : 입력 - 히든 레이어 - 출력

RNN : 입력 - 히든 레이어 - 한번 더 재귀(R) - 출력

X(t) : 앞에서 표현한 것의 압축본

First-order Mark (한번만 건너감)

Sequencet - to - sequence (seq2seq) : many-to-one + one-to-many

출력 = 시그마함수(가중치(입력) + 변수) : 시그마함수, activation function

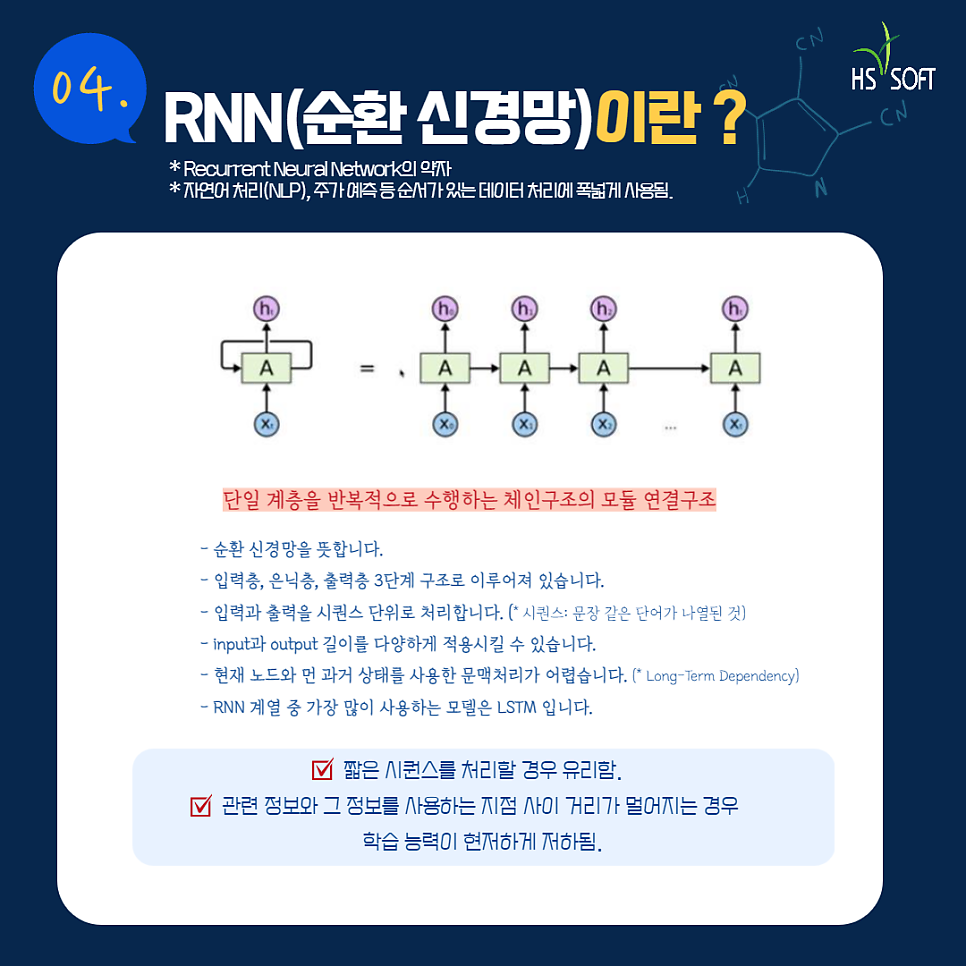

RNN의 한계 : Gradient Vanishing (정보가 많이 들어가면, 출력부분에 잊혀지는 한계 등)

장기적으로 기억을 못하는 한계 등

레이어를 깊게 쌓을수록 성능이 높아지다가, 점점 시간이 지남에 따라 성능이 떨어짐 등의 문제 등

보안하기 위한 모델 : LSTM

LSTM(Long Short Term Memory) : Ht(단기상태), Ct(장기상태) [LSTM 3개]

many-to-one + many-to-many를 입출력 하는 구조

(GRU(보안) : 입력 2개 등 좀 더 단순)

LSTM을 활용한 seq2seq 기계번역 아키텍처를 제안함

Encoders -> Decoders

언어모델 : 문장(시퀀스)에 확률을 부여하는 모델

통계적 언어 모델 : 카운트 기반의 접근을 사용

연쇄 법칙

RNN

RNN 문제해결 : Sequence-2-sequence (Context Vector)

< Seq2Seq(RNN) vs Transformer의 차이 >

순차적 vs 병렬적

RNN : 이전상태가 완전히 형성되어야지 다음으로 넘어감

Transformer : Self-Attention을 사용할 경우, Vector로 넘어가서 활용할 수 있음 등

RNN : 단일 계층을 반복적으로 수행하는 체인구조의 모듈 연결구조

입력층 - 은닉층 - 출력층

LSTM 제일 많이 사용

https://m.blog.naver.com/hansol7893/222620856622

딥러닝 알고리즘(ANN, DNN, CNN, RNN) 비교

안녕하세요 ! 에이치에스소프트입니다 :) 요즘 한파로 너무 추운거 같아요 ㅠ,ㅠ 빨리 봄이 왔으면 좋겠습...

blog.naver.com

'개인 프로젝트 > [LLM] 논문리뷰' 카테고리의 다른 글

| [논문리뷰] RoBERT 언어모델 발표자료 (0) | 2025.04.06 |

|---|---|

| [논문리뷰] 기계 번역 모델의 발전방향 및 비교 (1) | 2025.04.06 |

| [논문리뷰] BERT-RoBERTa (0) | 2025.04.01 |

| [논문] BERT : Bidirectional Encoder Representations from Transformers (0) | 2025.03.31 |

| [논문] Attention - Neural Machine Translation by Jointly Learning to Align and Translate (2014) (0) | 2025.03.19 |

댓글